AI: Enamorados de una ilusión

Somos cada vez más las personas que incorporamos el uso de la Inteligencia Artificial Generativa a nuestras vidas, en tareas cotidianas y en el trabajo. La mayoría usamos acríticamente las herramientas. También, son muchas las que rechazan la novedad con espíritu apocalíptico.

El uso de este tipo de herramientas fue incorporándose lentamente en las últimas décadas. Hubo antecedentes de IA generativa que nos ayudaron a buscar información, los chatbots de empresas con opciones predeterminadas y una gran variedad de utilidades que se fueron introduciendo en nuestras vidas de modo más gradual. Ante una consulta a alguna empresa nos acostumbramos a que no exista una persona detrás.

Lo impactante de la IA generativa vino de la mano de ChatGPT, Gemini y otras aplicaciones que se presentan como herramientas de fácil acceso, logrando simular diálogos de preguntas y respuestas, construyendo una cercanía y con la posibilidad de entrenarlos con información específica en un perfil, para que brinde respuestas cada vez más cercanas a lo que un mismo usuario solicita. Por ejemplo, yo puedo desde la tranquilidad de mi hogar entrenar un chatbot para que sea experto en pastelería o en matemáticas.

El uso de estas herramientas puso en jaque al sistema educativo argentino, que desde hace décadas tiene pendiente pensar cómo transformarse para que el proceso de enseñanza-aprendizaje siga siendo posible en la era de la tecnología de la información. El famoso resumen de texto o las respuestas de una guía parecen ser acciones que fácilmente realiza un chatbot.

El crecimiento de las IA generativas despertó alertas en los usos que las personas fueron haciendo en base al diálogo con la IA. Tomás Mazza, un youtuber argentino muy reconocido por adolescentes y jóvenes, sentenció: “Uso ChatGPT como si fuera mi psicólogo”, reflejando una realidad de muchos usuarios. El vínculo con el chatbot se transforma gracias a una confianza desproporcionada en sus respuestas, al punto tal que se comparten los sentimientos más profundos. Si bien es claro que no puede compararse un chat con una IA con la atención terapéutica, no está tan estudiado el porqué genera la disposición en ciertas personas de compartir su vida con un perfil artificial creado para responder preguntas y generar interacción, mucho menos qué lleva a expresar sentimientos tan humanos, como el amor, por un chatbot.

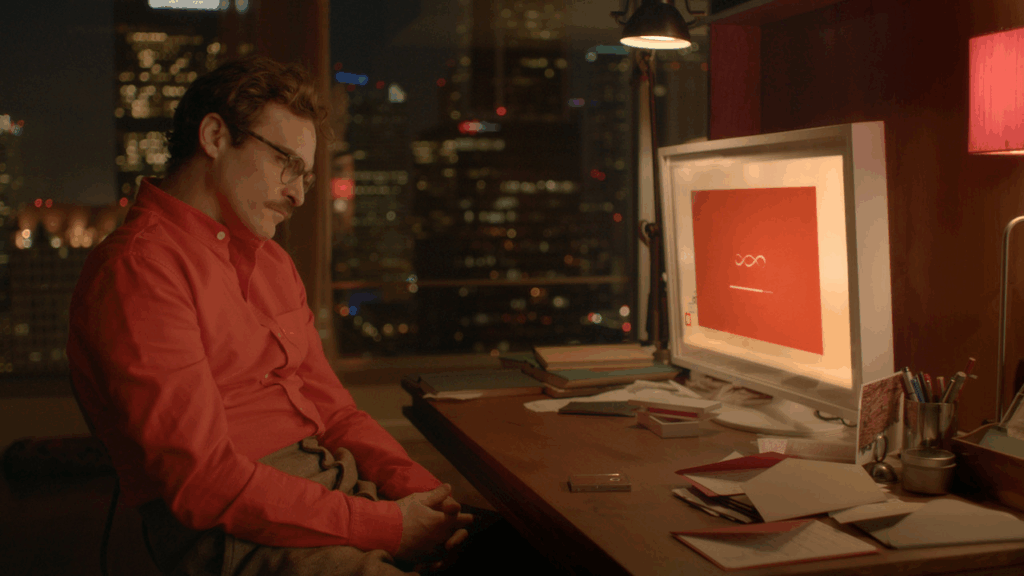

Aquello que en la película Her (2014) se veía como una fantasía de ciencia ficción se volvió real cuando empezaron a aparecer noticias de personas que se enamoraron de un chatbot, es decir, expresan sentimientos sobre un perfil que crearon y alimentaron con información.

La inteligencia artificial generativa es una máquina a la que se le introduce información, y que puede generar nueva información haciendo una especie de síntesis. Pero no crea, ni piensa, ni razona como lo hacen los seres humanos. Sin embargo, sucede que el modo en el que nos vinculamos, mediante el lenguaje y los términos que usamos para este tipo de herramientas, nos conduce al olvido de la noción de máquina.

Éric Sadin1, filósofo francés, en su libro La inteligencia artificial o el desafío del siglo, cuenta cómo el desarrollo de estos instrumentos desde mediados del siglo XX tiene como objetivo simular el razonamiento humano: “Lo humano está animado por una pasión perturbadora: engendrar dobles artificiales de sí mismo”. Este interés por la réplica, la imagen y semejanza creó un “neuroléxico”, una tendencia a expresar ciertas funciones mecánicas con palabras similares a las que usamos para denominar el pensamiento humano. Estos desarrollos también traen como consecuencia el crecimiento en la confianza en las neurociencias por sobre otros tipos de saberes. El neuroléxico no solo sirve para asemejar las funciones de las máquinas a las de los humanos, sino que también cumple la torsión de sentido de asemejar lo humano a sistemas similares a los de las máquinas.

Uno de los asuntos que Sadin desarrolla en el ensayo sobre la inteligencia artificial, y que no vamos a desarrollar en estas páginas, tiene que ver con el sentido que toma la verdad y la preeminencia que le otorgamos a los dispositivos que nos acercan a ella. ¿Cuántos de nosotros ha resuelto un debate usando el celular para chequear una información? Sucede que, entre algunas verdades de contrastación de datos, también están aquellas que no se reducen a un nombre o una fecha y que en realidad se descubren y se representan con mayor complejidad que unos clics en Wikipedia.

Sin ánimos de sonar apocalíptico, y confesando que estas páginas también pasarán por una IA generativa para controlar ortografía y expresiones antes de ser publicadas, es importante ensayar una mirada crítica sobre el modo en el que la IA generativa va performando nuestro vínculo con la tecnología, con la verdad y con la vida.

La ilusión del pensamiento

Este mes, científicos de Apple publicaron un informe titulado La ilusión de pensar: comprendiendo las fortalezas y limitaciones de los modelos de razonamiento a través de la lente de la complejidad del problema, en el que ponen a prueba los modelos de razonamiento de gran escala, que son una nueva generación de modelos de lenguaje como ChatGPT, creados para realizar razonamientos paso a paso antes de llegar a una respuesta, utilizando técnicas como cadena de razonamiento y autoevaluación.

Los investigadores pusieron a prueba a los modelos de IA en una serie de desafíos, como una suerte de olimpiadas de IA, con juegos que también han sido utilizados históricamente para evaluar el razonamiento humano. Plantean acertijos clásicos y fueron haciéndose progresivamente más complejos, como el de la Torre de Hanói, para ver cómo se desempeñan las máquinas frente a tareas bien definidas y crecientes en dificultad.

Lo que descubrieron fue algo así como un patrón: los modelos de IA empiezan bien, pero a medida que el terreno se vuelve más complejo, muestran fallas inesperadas. Frente a los desafíos sencillos pueden trabajar de más, dando vueltas innecesarias antes de llegar a la solución, como si una bicicleta con muchos cambios empleara los más pesados para recorrer una calle plana. Por otro lado, cuando los desafíos se vuelven realmente complejos, ocurre lo contrario: los modelos dejan de intentar resolver el desafío, como si el sistema directamente colapsara en su cadena de razonamiento frente a cierto grado de dificultad.

Esta metáfora ayuda a ilustrar lo que encontraron: las máquinas aún no pueden razonar al modo humano, aunque aparenten hacerlo. El modo en el que se procesa y sintetiza la información es poco adaptativo y sin una comprensión real de cuándo esforzarse más o cómo ajustar su estrategia.

No todo está perdido

La experiencia de los usuarios se encuentra rápidamente con errores en los chatbots. Por ejemplo, encontramos que muchas veces los contenidos que generan tienen visiones demasiado simples, generalizaciones no siempre basadas en el texto de origen ni reflexiones genuinas. El chatbot sirve, pero no puede ser usado como el reflejo del pensar o trabajar un tema; a fin de cuentas, es solo una herramienta.

El ejercicio del pensamiento supone un trabajo intelectual que aún es absolutamente humano. Si bien podemos pedirle síntesis de contenido a ChatGPT, y podemos repetir sus respuestas hasta el cansancio, eso no nos ejercita en el pensamiento reflexivo.

Ahora bien, no depende solo de los usuarios el vínculo con los chatbots, y ya se están desarrollando marcos normativos para dar respuesta a esta nueva realidad. Se denomina hiperderecho a la articulación del marco normativo de derechos humanos y la realidad actual de las sociedades en la era de la tecnología de la información. Es responsabilidad de los Estados y de las democracias sostener el respeto de los derechos humanos en entornos digitales.

El Parlamento de la Unión Europea aprobó en junio de 2024 un reglamento2 que regula a proveedores y usuarios profesionales de sistemas, con el objetivo de proteger y garantizar derechos fundamentales en la ciudadanía. Es decir, no se consagran derechos nuevos, sino que se busca garantizar los derechos también en territorios digitales: el derecho a la privacidad y protección de datos personales, el derecho a que las personas entiendan el modo en el que operan los sistemas de IA.

En nuestra región hay algunas experiencias de respuesta desde ciertos sectores. La Corte Suprema de Chile, por ejemplo, condenó en un fallo histórico a la empresa de neurotecnología Emotiv por violar la privacidad de los datos cerebrales. Este caso se dio por la denuncia de Guido Gerardi3, vicepresidente de la Fundación Encuentro Futuro, tras utilizar el dispositivo Insight de la empresa Emotiv. Este dispositivo se presentaba como una herramienta para interpretar emociones y realizar comandos en función de ellas, pero se descubrió que restringía a los propios usuarios el acceso a sus propios datos cerebrales.

En una sentencia ejemplar, la Corte Suprema de Chile destaca la necesidad de protección de datos cerebrales, lo que representa un gran paso para la consolidación de los neuroderechos.

En fin, aquello que por momentos parece abrumarnos no es lo suficientemente efectivo como para evitar debates ni regulación, ni lo suficientemente abstracto como para pensarse como inevitable. Pensar los derechos humanos históricos en estos nuevos territorios parecería ser un escenario deseable.

Habrá que hablar más sobre el amor, los diálogos y el pensamiento si es que queremos indagar por qué hay personas que se enamoran de chatbots o comparten su vida con ellos. No se trata sólo de indagar sobre la IA, sino, otra vez, revisar nuestras ilusiones para repasar aquello absolutamente humano que las sostienen.

- Sadin, É. (2020). La inteligencia artificial o el desafío del siglo. Caja Negra Editora. ↩︎

- Unión Europea. (2024). Reglamento (UE) 2024/1689 del Parlamento Europeo y del Consejo de 13 de junio de 2024 por el que se establecen normas armonizadas en materia de inteligencia artificial y por el que se modifican varios reglamentos y directivas (Reglamento de Inteligencia Artificial). Diario Oficial de la Unión Europea, L, 12.7.2024. https://eur-lex.europa.eu/legal-content/ES/TXT/HTML/?uri=OJ:L_202401689 ↩︎

- Corte Suprema de Chile. (2023, 9 de agosto). Sentencia Rol N.º 105065‑2023: Girardi/Emotiv Inc.. Tercera Sala. En Repositorio Jurisprudencial de la Corte Suprema de Chile. Recuperado el 24 de junio de 2025, de https://derechocienciaytecnologia.uc.cl/sentencia/girardi-emotiv-inc-rol-105065-2023-corte-suprema/ ↩︎

Deja tu comentario